Los primeros programas de inteligencia artificial que derrotaron a los mejores jugadores de ajedrez y del Go, necesitaron instrucciones humanas. Pero la nueva generación de programas de inteligencia artificial es mucho más avanzada, aprende completamente por su cuenta con lo que se conoce como aprendizaje cooperativo.

Los programas de IA se han vuelto campeones de juegos con una combinación de aprendizaje profundo y algoritmos de aprendizaje por refuerzo. Pero cuanto más se asemeja el juego a la vida real, las computadoras más se atascan. Es decir, cuando hay información oculta, múltiples jugadores, juegos continuos y una combinación de recompensas a corto y largo plazo que hacen que el cálculo del movimiento óptimo sea totalmente complejo.

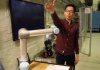

Así que pensando en cómo superar ese tipo de obstáculos, los investigadores están probando técnicas complementarias para ayudar a los robots a aprender. El modelo replica la forma en que los humanos recopilan nueva información. Nosotros no solo aprendemos desde nosotros mismos, sino también a través de lo que dicen otras personas, de los libros, los periódicos, los medios de comunicación,etc.

Pensando en eso, MIT-IBM Watson AI Lab está desarrollando una estrategia de aprendizaje cooperativo. Los investigadores han descubierto que un par de agentes de robots pueden reducir el tiempo que lleva aprender una tarea de navegación sencilla en un 50% o más, cuando aprovechan el creciente cuerpo de conocimiento de los demás.

Así que el nuevo algoritmo enseña a los agentes a pedir ayuda cuando es necesario, y a dar consejos acerca de lo que han aprendido hasta el momento. Así que ninguno de los agentes es un experto, más bien es libre de solicitar información para aprender. Este trabajo fue presentado en la Conferencia AAAI sobre Inteligencia Artificial en Hawai.

Los autores del estudio son Jonathan How, profesor del Departamento de Aeronáutica y Astronáutica del MIT; Shayegan Omidshafiei, un ex estudiante graduado del MIT ahora en Alphabet’s DeepMind; Dong-ki Kim del MIT; Miao Liu, Gerald Tesauro, Matthew Riemer y Murray Campbell de IBM; y Christopher Amato de Northeastern University. Por su lado, Matthew E. Taylor, director de investigación de Borealis AI, el brazo de investigación del Royal Bank of Canada, quien no participó en la investigación, opinó al respecto:

“Esta idea de proporcionar acciones para mejorar en gran medida el aprendizaje como estudiante, en lugar de simplemente decirle qué hacer, es potencialmente muy poderosa. Si bien el documento se enfoca en escenarios relativamente simples, creo que el marco del alumno / maestro podría ampliarse y ser útil en videojuegos para múltiples jugadores como Dota 2, fútbol robot o escenarios de recuperación de desastres”.

El artículo ya fue premiado con una mención honorífica al mejor artículo de estudiante en AAAI. Y como bien decía Taylor, es una idea potencial para los nuevos programas de AI. Lo que el aprendizaje cooperativo promete no solo es facilitar a las máquinas su funcionamiento y que ya no se traben, sino una manera de aprendizaje mucho más fluido (no programado) y en todo caso, parecido al humano.